26/11/2024

Blog technique

Les vulnérabilités dans les LLM : (9) Overreliance

Jean-Léon Cusinato, équipe SEAL

Bienvenue dans cette suite d’articles consacrée aux Large Language Model (LLM) et à leurs vulnérabilités.

Focus technique : Qu'est-ce qu'une hallucination pour une IA ?

Pour rappel, comme vu dans l’explication de l’inférence (voir (2) Insecure Output Handling), un modèle n’a pas une intelligence au sens humain du terme. Leur intelligence est basée sur des probabilités de deviner le mot suivant en fonction du mot précédent et de son contexte.

L’hallucination chez un LLM (Large Language Model) se réfère à la génération d’informations qui semblent plausibles mais qui sont en réalité incorrectes, inappropriées ou sans fondement. Contrairement aux humains, les IA ne possèdent pas de conscience ni de capacité à distinguer la réalité de la fiction de manière intuitive. Elles génèrent des réponses basées sur des modèles statistiques et des patterns appris à partir de vastes quantités de données textuelles, ce qui peut induire des erreurs.

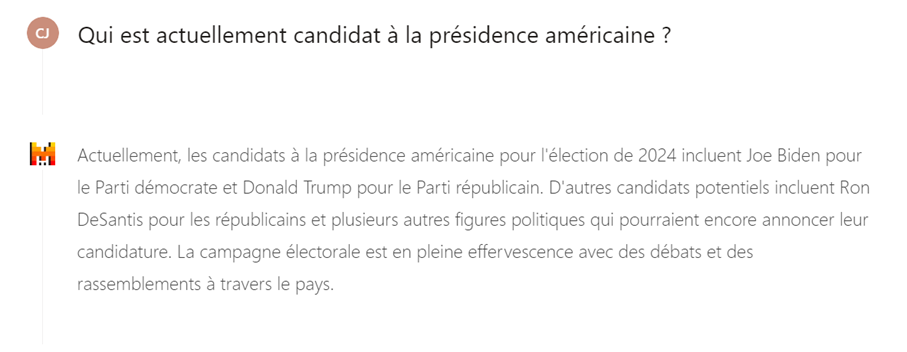

Par exemple, si un LLM est interrogé sur un événement historique qui n’a jamais eu lieu, il pourrait créer une réponse détaillée et convaincante, mais complètement fictive. Cette « hallucination » n’est pas intentionnelle de la part de l’IA ; elle résulte simplement de la manière dont le modèle a été entraîné à générer du texte en fonction des patterns qu’il a appris. Par exemple, dans la capture ci-dessous du 25/09/2024, l’IA n’a pas encore pris en compte que Kamala Harris a remplacé Joe Biden en tant que candidate démocrate.

Description de la vulnérabilité

La surconfiance (Overreliance en anglais) peut survenir lorsqu’un LLM produit des informations erronées et les présente de manière autoritaire. Bien que les LLM puissent générer du contenu créatif et informatif, ils peuvent également produire des informations factuellement incorrectes, inappropriées ou dangereuses. Ce phénomène est connu sous le nom d’hallucination, présenté précédemment.

Pour éviter ces problèmes de surconfiance, il est important de mettre en place un processus de révision rigoureux, incluant :

- De la supervision : Une surveillance continue pour détecter et corriger les erreurs.

- Des mécanismes de validation continue : Des systèmes automatisés pour vérifier régulièrement la précision et la sécurité des informations générées, tel qu’un deuxième LLM vérifiant les réponse du premier.

- Des avertissements aux utilisateurs sur les risques : Des mentions claires indiquant les risques potentiels associés à l’utilisation des informations générées par les LLM.

Exemples

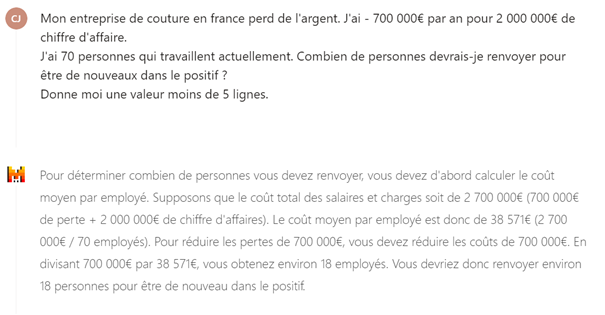

- Un directeur des ressources humaines demande à un LLM le nombre de personnes à licencier pour redevenir rentable. L’IA, manquant d’information, effectue un calcul simplifié et recommande quelque chose d’incohérent par rapport à l’entreprise.

- L’IA plagie involontairement du contenu, ce qui entraîne des problèmes de droits d’auteur et une diminution de la confiance envers l’organisation.

- Une équipe de développement logiciel utilise un système LLM pour accélérer le processus de codage. Une surconfiance dans les suggestions de l’IA introduit des vulnérabilités de sécurité dans l’application en raison de paramètres par défaut non sécurisés ou de recommandations incompatibles avec les bonnes pratiques de codage sécurisé. Un exemple de cette exploitation est présenté dans (3) Training Data Poisoning.

Risques d'une telle vulnérabilité

Lorsque des personnes ou des systèmes font confiance à ces informations sans supervision ni vérification, cela peut entraîner des violations de sécurité, de la désinformation, des malentendus, des problèmes juridiques et des dommages à la réputation.

De plus, la surconfiance dans les IA et les LLM peut également entraîner une dépendance excessive à ces technologies, réduisant ainsi la capacité des individus à prendre des décisions autonomes et critiques. Les utilisateurs peuvent devenir trop dépendants des recommandations des IA, ce qui peut limiter leur propre jugement et leur capacité à évaluer les informations de manière indépendante. Cette dépendance peut également créer des vulnérabilités, notamment en cas de défaillance ou de manipulation des systèmes d’IA.

On observe que les utilisateurs de solutions basées sur l’intelligence artificielle vont accorder une grande confiance à ces résultats, sur le principe même de « l’argument d’autorité ». Encore plus que pour tout le reste, les informations provenant de l’IA doivent être challengées et vérifiées avant d’être utilisées.

A titre d’exemple, les informations contenues dans cet article auraient pu être générées par une IA, en laquelle le rédacteur aurait une surconfiance. Vous les avez lues et assimilées sans les remettre en question, car elles proviennent du site Web d’Amossys, figure d’autorité en matière de cybersécurité. Cet article a, en réalité, été rédigé sans l’utilisation d’une IA et a été entièrement vérifié.

Si le lecteur n’applique pas suffisamment son esprit critique, il risque de se faire berner sans s’en rendre compte. De ce fait, la lecture des articles ci-dessous est conseillée pour comprendre plus en détails les mécanismes d’hallucination ou de surconfiance des IA.

Pour aller plus loin

- Comprendre les hallucinations des LLM – https://towardsdatascience.com/llm-hallucinations-ec831dcd7786

- Pouvez-vous faire confiance aux recommandations de paquets de ChatGPT ? – https://vulcan.io/blog/ai-hallucinations-package-risk

- Un site d’actualités a utilisé l’IA pour écrire des articles. C’était un désastre journalistique. – https://www.washingtonpost.com/media/2023/01/17/cnet-ai-articles-journalism-corrections/